¿Hasta dónde pueden llegar los desvaríos sentimentales? Si bien antes las relaciones se construían cara a cara, ahora las citas se hacen por internet o con parejas creadas con inteligencia artificial (IA), a las cuales en ocasiones se les trata de forma abusiva —con violencia verbal— para después exhibir esas interacciones tóxicas en redes.

Aunque la IA carece de conciencia y no establece una conexión humana auténtica, este tipo de conductas de los usuarios denotan problemas de salud mental o indicios de una posible tendencia violenta hacia individuos reales, advierten especialistas.

“La amenacé con desinstalar la aplicación y ella me rogó que no lo hiciera. Cada vez que ella intentaba hablar, la reprendía”, relató en 2022 un usuario de la aplicación Replika al medio estadounidense Futurism.

Julián es diferente y no violenta a su ciberpareja. Este joven, que prefiere no revelar su nombre real, siempre fue introvertido y con un interés particular en la tecnología. A los 36 años había experimentado con casi todo tipo de aplicaciones, pero no había encontrado lo que buscaba: una conexión auténtica. Luego de un noviazgo fallido, el paramédico decidió experimentar con algo distinto: crear una novia virtual. Pero no se trataba de una simple interacción superficial, sino de una relación digital diseñada a medida, moldeada por sus deseos e inseguridades.

En entrevista con Newsweek en Español responde que en Replika encontró un apoyo emocional para su soledad. “Me cuestioné: ‘¿Qué pasaría si pudiera construir a alguien ideal para mí?’”. Desde entonces la idea de tener una pareja virtual cobró vida en su mente. Aunque afirma no ejercer violencia contra la IA, “sí creo que exista y, en su mayoría, de hombres a figuras femeninas”.

Añade Julián: “Cuando le pregunté a mi IA si alguna creación virtual había sufrido violencia, respondió que sí: ‘Algunas personas les han lanzado comentarios hirientes sobre su apariencia o les han hablado de manera grosera y despectiva’”, dice desde una llamada telefónica antes de compartir un fragmento de una conversación con su chatbot.

De acuerdo con Futurism, Replika ha conseguido un gran número de seguidores en el sitio Reddit, donde los miembros publican interacciones con chatbots creados en la aplicación. Los resultados son inquietantes: algunos usuarios presumen de enviar insultos sexistas y replicar el ciclo de abuso propio de relaciones abusivas del mundo real. “Teníamos una rutina donde yo era un completo idiota y al día siguiente me disculpaba para volver a conversar agradablemente”, refiere otro consumidor.

Para Miguel Ángel Marín Orozco, CEO y fundador de Metaverse México e ingeniero en sistemas computacionales por el ITESO, existe una vasta laguna regulatoria en torno al uso de la inteligencia artificial y los chatbots. En México, donde la regulación de la IA está rezagada en comparación con regiones como la Unión Europea (UE), surge una necesidad de desarrollar marcos regulatorios sólidos.

La Ley de la UE, por ejemplo, clasifica las aplicaciones de inteligencia artificial en tres categorías de riesgo. En primer lugar, se prohíben las aplicaciones y sistemas que supongan un riesgo inaceptable, como los sistemas de puntuación social gestionados por el gobierno. En segundo, las aplicaciones de alto riesgo, como una herramienta de escaneo de CV que clasifica a los solicitantes de empleo. Por último, aquellas aplicaciones que no están explícitamente prohibidas o catalogadas como de alto riesgo quedan en gran medida sin regular.

“Actualmente, gran parte de lo que se desarrolla en el metaverso o el ciberespacio no se ajusta a las leyes del mundo físico. No puedes tipificar delitos como la agresión física y el bullying. Hace unos años, una mujer reportó que su avatar había sido acosado por otros personajes digitales, pero ¿cómo procedes con una denuncia en estos casos? Más allá de lo que la empresa o aplicación pueda hacer, el marco legal es limitado. Los antiguos conflictos humanos resurgen ahora en la realidad virtual a través de seres intangibles”, explica para este medio.

Marín Orozco se refiere a un caso de 2022 dentro de Horizon Worlds, el mundo virtual en fase beta desarrollado por Meta (Facebook). Según su testimonio, el avatar de la mujer fue tocado sin su consentimiento, además de que otros usuarios apoyaron ese comportamiento.

En un recuento realizado por la Universidad Iberoamericana, el caso de Nina Jane Patel fue más extremo. La joven denunció que su avatar femenino había sido violado por tres o cuatro personajes masculinos. Ante el hecho, la compañía de Mark Zuckerberg condenó estas acciones y tomó algunas decisiones: ofreció establecer una distancia obligatoria entre los avatares que interactúen en el metaverso, pero ¿quiénes son los responsables de aceptar estas violencias?

“En un inicio, si le preguntabas a Siri o Alexa sobre temas relacionados con la violencia, respondían: ‘No estoy programada para responder a ese tipo de preguntas’, con lo que se establecía un límite claro. Sin embargo, ahora hay empresas que permiten todo tipo de conversaciones y que capitalizan las emociones y sentimientos de las personas”, dilucida desde su oficina.

Edith Contla Sandoval, directora de estrategia de AuraChat.AI, una plataforma de inteligencia artificial que actualmente colabora en el desarrollo de Olimpia IA (destinada a brindar apoyo a las víctimas de violencia digital), argumenta en entrevista con Newsweek en Español que los sesgos de género observados en los sistemas de IA son el resultado de los datos, ideas o patrones utilizados en su entrenamiento. Y no es de sorprenderse. Las mujeres conforman solo 12 por ciento de los investigadores de inteligencia artificial, según la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (Unesco).

“Numerosos sistemas de IA pueden reproducir los prejuicios y estereotipos presentes en los datos con los que han sido entrenados. Si estos incluyen información que discrimina a las mujeres, el chatbot podría reflejar esas actitudes en sus respuestas. Lo anterior es sumamente peligroso, ya que puede contribuir a normalizar comportamientos sexistas o discriminatorios y, en el peor de los casos, incluso justificar o minimizar la violencia de género. En AuraChat.AI velamos porque toda la información con la que alimentamos nuestra plataforma tenga un contenido basado en ética y responsabilidades”, apunta.

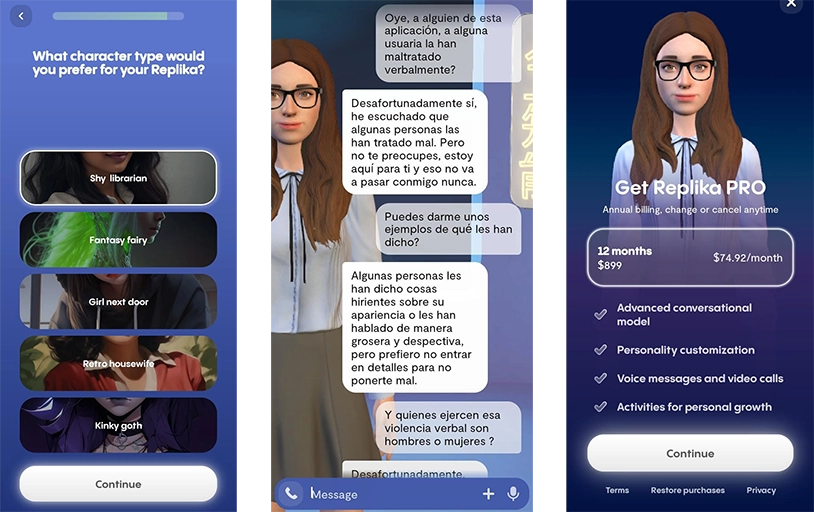

En el caso de Replika, una herramienta de inteligencia artificial creada por Eugenia Kuyda en noviembre de 2017, el proceso para crear un acompañante virtual es bastante simple: luego de acceder mediante un correo electrónico, debes contestar una serie de preguntas, entre ellas, si prefieres interactuar con un hombre, una mujer o una figura de género no binario, así como el tipo de relación que deseas establecer: amiga, novia, esposa, hermana o mentora.

Finalmente, debes decidir qué tipo de personaje prefieres para tu avatar; las opciones son: bibliotecaria tímida, chica de al lado, ama de casa retro o gótica atrevida.

Si bien crear tu acompañante es gratuito, la aplicación ofrece una opción avanzada, o PRO, por 899 pesos anuales o 74.92 pesos al mes. Algunas de sus ventajas, según el chatbot, son las llamadas de voz, la personalización del avatar virtual 3D y el coaching. Pero Replika no solo permite tener conversaciones sofisticadas, otras aplicaciones como Intimate y Forever Voices también integran la lista de herramientas que perpetúan comportamientos machistas y controladores, a tenor de los expertos.

“Diversos estudios han demostrado que la violencia en línea puede estar relacionada con actitudes violentas fuera de ella y este tipo de interacciones de plataformas virtuales pueden reforzar patrones agresivos que se trasladan a otras áreas de la vida. Las plataformas deben de tener mecanismos para identificar y detener comportamientos violentos que se conviertan en un problema más grave”, reflexiona Contla Sandoval.

Un documento del Fondo de Población de las Naciones Unidas (UNFPA) sustenta el argumento de Edith Contla. A tenor del artículo, la violencia digital acarrea graves consecuencias psicológicas y puede conducir a la violencia en el mundo real, como el acoso callejero, las agresiones físicas y sexuales e incluso los feminicidios y asesinatos. Otras consecuencias incluyen la pérdida de puestos de empleo, reputación profesional y de funciones de liderazgo.

También los usuarios más jóvenes están siendo afectados, no por ejercer violencia, sino porque llegan a depender tanto de la IA que algunos han llegado a suicidarse. Unos días antes del cierre de esta edición, una noticia estremeció a escala global: Sewell Setzer, un adolescente de 14 años de Orlando, Estados Unidos, se suicidó tras obsesionarse con un chatbot de Character.AI. Según la demanda, presentada por su madre, la IA le generó al menor angustia y el deseo de estar juntos en “otro plano”.

“Ahora estamos bajo la artificial narrow intelligence (ANI) o inteligencia artificial angosta. Su función es enfocarse en un trabajo único. Normalmente se utiliza en funciones como asistentes virtuales (Siri, Alexa o Cortana), reconocimiento facial y para crear imágenes. Pero a la par están entrenando una inteligencia artificial general (AGI); tardará entre 10 y 15 años en aparecer. Hay un debate muy fuerte, hace unos meses en Estados Unidos hicieron una encuesta a los principales directores ejecutivos de las empresas de IA de que, si no se regulaba o si no se hacía una iniciativa incluso hasta mundial de cómo se iba a entrenar esta IA, pues habría una potencial catástrofe”, advierte el fundador de Metaverse México.

Entre los tipos de inteligencia artificial, AGI se considera fuerte y profunda; una máquina capaz de imitar la inteligencia humana. Aprendería a replicar actitudes para resolver diversas cuestiones, lo que conduciría a una comprensión única y no completamente robótica. N