Un equipo de científicos de la Universidad del Oeste de Inglaterra en Bristol (UWE) y el Colegio Rural de Escocia está trabajando en el desarrollo de un sistema de inteligencia artificial llamado Intellipig, diseñado para identificar las expresiones faciales de los animales y determinar si están tristes, angustiados o felices, con el objetivo de mejorar su bienestar.

No obstante, según Science, Intellipig no es el único proyecto en esta área. Investigadores de diversas partes del mundo también están utilizando la inteligencia artificial para interpretar las expresiones de diferentes especies, desde ovejas y caballos hasta gatos.

“Estas herramientas podrían marcar el comienzo de una nueva era en el cuidado de los animales que dé mayor prioridad a su salud, bienestar y protección. Con el tiempo, la IA podría incluso superar a los humanos en la interpretación de una gama de emociones más complejas, como la felicidad, la serenidad, la frustración y el miedo”, comenta Melvyn Smith, ingeniero de visión artificial de la UWE que dirigió el diseño del sistema Intellipig, a la revista científica Science.

En particular, el sistema Intellipig lo están probando en cerdos. El estudio consiste en capturar el rostro del animal con una pequeña cámara mientras está comiendo. En menos de un minuto, el sistema de IA identifica al mamífero basándose únicamente en su hocico, orejas, ojos y demás rasgos faciales.

“La IA ordena una comida personalizada para inyectarla en el comedero; mientras tanto, el sistema sigue analizando su fotografía en busca de signos reveladores en su expresión facial que indiquen que podría estar sufriendo, enfermo o en estado de angustia. Si encuentra alguno envía una alerta inmediata al granjero”, refiere el artículo.

A tenor de los especialistas, los mamíferos, incluidos los humanos, tienen muchos músculos comunes cuyo propósito es crear expresiones faciales. Las personas comparten 38 por ciento de sus movimientos del rostro con los perros, 34 por ciento con los gatos y un 47 por ciento con los primares y los caballos.

A pesar de las similitudes anatómicas, esto no significa que podamos leer los rostros de los animales. Por ello, los investigadores que estudian la comunicación animal a menudo infieren lo que el ser está experimentando a través del contexto.

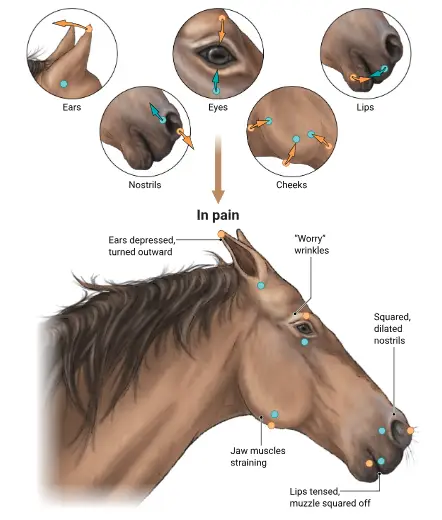

En esa vía, algunos científicos han pasado miles de horas sentados frente a establos y jaulas observando las caras de los animales en situaciones dolorosas o estresantes para luego compararlas con las de otros seres que probablemente no sentían dolor ni estrés. Como resultado han desarrollado “escalas de muecas” para diversas especies, que proporcionan una medida de cuánto sufrimiento experimenta un animal en función de sus músculos faciales.

Por ejemplo, un caballo que gira las orejas hacia afuera mientras forma “arrugas de preocupación” sobre los ojos tiene más probabilidades de sufrir dolor que uno que mantiene las orejas y los ojos relajado, según Pia Haubro Andersen, cirujana de caballos de la Universidad Sueca de Ciencias Agrícolas.

“Los caballos indican estrés con movimientos y arrugas de orejas similares, pero con diferencias sutiles como mostrar la lengua”, dice.

Los expertos en este campo han adquirido la habilidad de codificar manualmente estos movimientos faciales en animales. De acuerdo con Science, los codificadores humanos necesitan un promedio de 100 segundos para identificar los diversos músculos faciales y sus posiciones en una sola imagen o de 2 a 3 horas para 30 segundos de video. En tanto, la IA puede realizar la misma tarea casi al instante. N