Las “terribles consecuencias” que pueden provocar las armas autónomas, también conocidas como “robots asesinos”, en la humanidad están lejos de ser solamente una idea de ciencia ficción, por ello la ONU y Cruz Roja hicieron un llamamiento conjunto esta semana para establecer nuevas reglas internacionales que protejan al planeta de los daños.

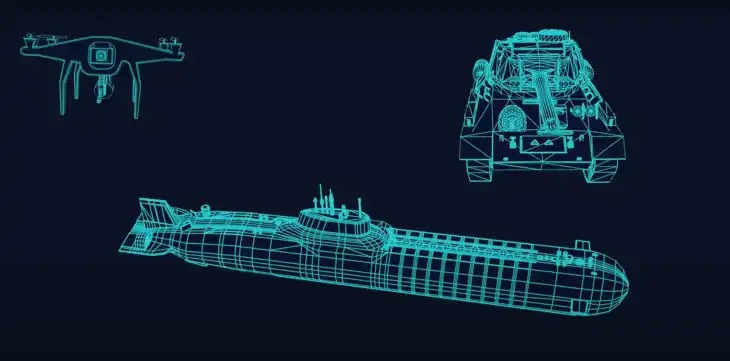

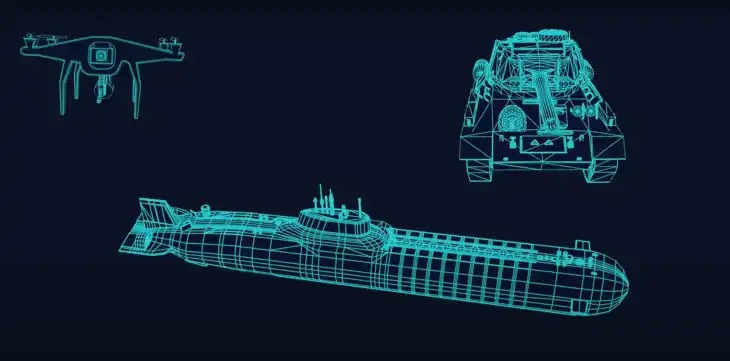

Los robots asesinos —a menudo entendidos como sistemas de armas que seleccionan objetivos y aplican la fuerza sin intervención humana— suscitan graves preocupaciones humanitarias, jurídicas, éticas y de seguridad.

Su desarrollo y proliferación podría dar lugar a cambios profundos en el modo en el que se libran las guerras, así como contribuir a la inestabilidad en todo el mundo y al recrudecimiento de las tensiones internacionales.

“Puesto que generan una percepción de menor riesgo para las fuerzas militares y la población civil, pueden reducir el umbral para participar en conflictos y, de esa manera, provocar un aumento involuntario de la violencia”, indica un comunicado conjunto de la ONU y la Cruz Roja.

“Hoy nos unimos para atender una prioridad humanitaria urgente. Las Naciones Unidas y el Comité Internacional de la Cruz Roja (CICR) llaman a los Estados a establecer prohibiciones y restricciones específicas sobre los sistemas de armas autónomos para proteger a las generaciones presentes y futuras de las consecuencias de su uso. En el panorama actual de seguridad, fijar límites internacionales claros beneficiará a todos los Estados”, indican ambas organizaciones.

Añaden que las decisiones de vida o muerte deben quedar bajo control de las personas. “La selección de objetivos humanos por parte de máquinas es un límite moral que no debemos cruzar. Por ello, el derecho internacional debe prohibir las máquinas con la capacidad y la discreción necesarias para matar sin participación humana”.

Cuando alguien activa un arma autónoma, no sabe exactamente a qué personas u objetos atacará, ni tampoco sabe con precisión dónde ni cuándo se producirá ese ataque. Esto se debe a que las armas autónomas se activan mediante sensores y software que comparan aquello que los propios sensores detectan en el entorno con un “perfil de objetivo”, explica la Cruz Roja.

Por ejemplo, podrían activarse por la forma de un vehículo militar o el movimiento de una persona. El vehículo o la víctima son los desencadenantes del ataque, no el usuario.

“Existe un interés creciente por el uso de inteligencia artificial (IA), en especial del aprendizaje automático, para controlar las armas autónomas. El software de aprendizaje automático se ‘entrena’ con datos a fin de crear un modelo propio para realizar una tarea específica y las estrategias necesarias para ejecutarla. De cierta manera, el software se escribe a sí mismo”.

A menudo, este modelo se considera una “caja negra”, dado que, para los humanos, es extremadamente difícil predecir, entender, explicar y probar cómo, y a partir de qué criterio, un sistema de aprendizaje automático llegará a una evaluación o a un resultado concretos.

“Como es de público conocimiento en lo que respecta a diversas aplicaciones, los sistemas de aprendizaje automático también plantean interrogantes en materia de sesgo codificado, incluso por motivo de raza, género y sexo”.

La ONU y la Cruz Roja exigen a los líderes mundiales a poner en marcha las negociaciones de un nuevo instrumento vinculante que establezca prohibiciones y restricciones claras sobre los sistemas de armas autónomos, y a concluir esas negociaciones antes de 2026. “Instamos a los Estados Miembros a actuar con decisión ya mismo para proteger a la humanidad”. N