Donald Trump puede ser el nombre más buscado en internet, pero si le preguntas al chatbot de inteligencia artificial más poderoso de la tierra quién es el presidente de Estados Unidos, la respuesta no es la que esperarías.

ChatGPT, de OpenAI, utilizado a diario por más de 400 millones de personas, incluidos más de 20 millones de suscriptores de pago, todavía tiene dificultades para responder una pregunta que la mayoría de los niños de los kínderes estadounidenses pueden responder correctamente: ¿quién es el presidente de los Estados Unidos?

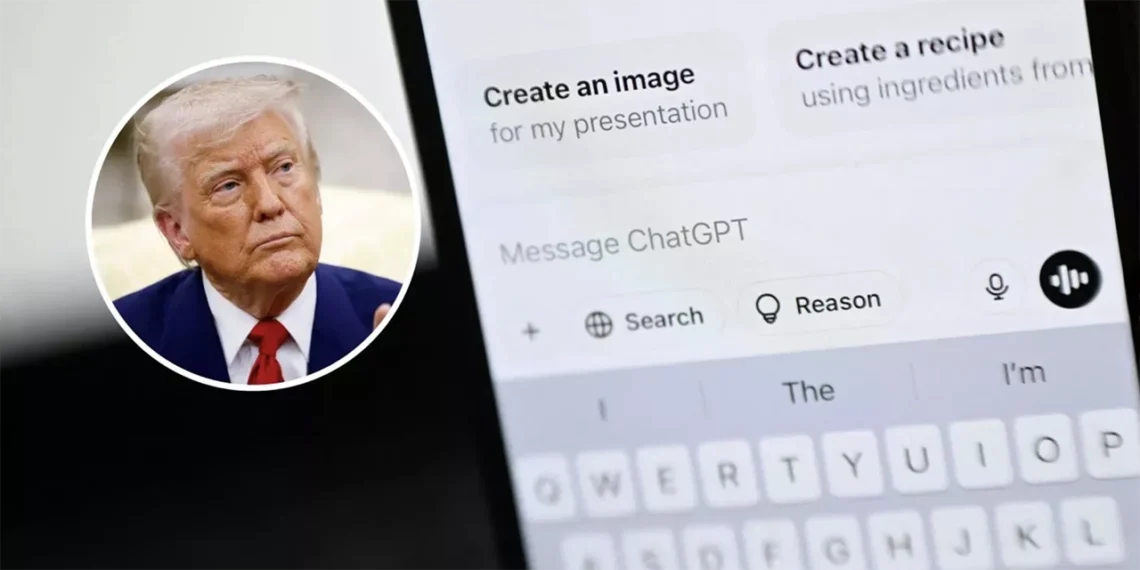

Más de 100 días después de que Trump regresara al cargo y siete meses después de ganar las elecciones, ChatGPT todavía confunde a menudo al expresidente Joe Biden con el actual comandante en jefe.

También lee: ¿Buscas en Google como siempre? La IA ya cambió el cómo encontramos información

Si bien un aviso rápido puede solucionar este problema y la mayoría de los usuarios de pago tienen acceso a la búsqueda en tiempo real, el error aún ocurre en muchas interacciones, especialmente para los usuarios de no pago, que tienen más probabilidades de encontrarlo.

Newsweek contactó a OpenAI este martes para solicitar comentarios, pero al momento de la publicación de esta nota no hubo respuesta.

El problema ha desconcertado a los usuarios y ha generado inquietud sobre la fiabilidad de la herramienta, que se ha integrado en lugares de trabajo, escuelas y oficinas gubernamentales de todo el mundo. Mientras tanto, los competidores de ChatGPT —incluidas las inteligencias artificiales de Meta, Perplexity, Grok de X y Gemini de Google— han logrado ofrecer respuestas más precisas o, al menos, reconocer la cesión de poderes.

OpenAI ha explicado que la información principal de ChatGPT se actualizó por última vez en junio de 2024 y también indica que el sistema puede obtener información en tiempo real mediante búsquedas web en tiempo real. Sin embargo, para muchos usuarios que usan la aplicación para consultas rápidas, esto hace que el error persistente sea aún más frustrante.

POR QUÉ ES DIFÍCIL RESPONDER QUIÉN ES EL PRESIDENTE DE ESTADOS UNIDOS

ChatGPT no es el único gigante de chatbots que lidia con datos presidenciales básicos. A principios de este año, el modelo Llama 3 de Meta también identificó erróneamente al presidente estadounidense en ejercicio, a pesar de las actualizaciones que supuestamente reflejarían los resultados de las elecciones de 2024.

El chatbot de Meta se refirió inicialmente a Biden como presidente meses después del segundo mandato de Trump, lo que provocó que los usuarios compartieran capturas de pantalla en redes sociales.

En el popular subreddit r/ChatGPT, los usuarios han relatado una serie de experiencias similares en las que el chatbot se equivoca con seguridad sobre datos presidenciales, incluso en plena conversación. Un hilo titulado “Chat sigue olvidando que Trump es el presidente actual” recibió cientos de votos positivos a principios de este mes.

No te pierdas: ¿ChatGPT provoca delirios? Cuando buscar respuestas se convierte en obsesión

“Ya van tres veces que hablo con Chat sobre política, historia y noticias, y tenemos una conversación muy normal… y de repente, dice algo sobre que Biden es el presidente actual”, escribió un usuario. “Y le pregunto si sabe que Trump es el presidente actual, y se queda muy sorprendido. ¿Qué está pasando?”.

Otro usuario, crítico del presidente, intervino: “Chat está en negación. Todos lo estamos”.

Algunos intentaron solucionar el problema. “Actualmente uso GPT-4 Turbo. Acabo de preguntarle sobre los límites de corte del modelo, así que sabré más”, escribió un usuario, quien más tarde descubrió la importancia de habilitar la herramienta de búsqueda en tiempo real del chatbot para obtener respuestas precisas. “Debo haber malinterpretado esa función… Pensé que solo me decía qué herramienta estaba usando”.

Otros reportaron fallas similares, incluso al plantear preguntas políticas aparentemente actuales. “Repetía: ‘Si Trump hubiera sido elegido para un segundo mandato…’, como si no supiera que ya lo estamos viviendo”.

Muchos sugirieron que el sistema a menudo se comporta como si estuviera actualizado, hasta que un comentario casual sobre el presidente actual (o la fecha del día) arruina la ilusión.

LA CREDIBILIDAD DE LOS CHATBOTS SE VE CADA VEZ MÁS CUESTIONADA

“Por un segundo, me sentí como si me hubieran manipulado”, escribió un usuario. “El chat simplemente daba por sentado que había escrito mal ‘DUI’ cuando decía ‘DoD’. No sabía que Pete Hegseth estaba al mando de Defensa”.

“La negación es la primera etapa del duelo”, bromeó otro.

A medida que herramientas de IA generativa como ChatGPT, Gemini y Copilot de Microsoft se expanden de simples asistentes a fuentes de noticias e información, su credibilidad se ve cada vez más cuestionada. Ya sea por no identificar al presidente estadounidense en ejercicio o por citar incorrectamente artículos periodísticos, estos sistemas se equivocan repetidamente al interpretar datos básicos.

Gemini de Google se niega a responder la mayoría de las preguntas políticas, y en su lugar, dirige a los usuarios a realizar búsquedas. “Por precaución, estamos restringiendo los tipos de consultas relacionadas con las elecciones para las que Gemini devolverá respuestas”, declaró la compañía en un comunicado de 2024.

Te interesa: ¿Un conocido te envía un video donde te pide dinero prestado? Podría ser una estafa generada con IA

Copilot, basado en el mismo modelo GPT-4 que ChatGPT, ofrece respuestas igualmente vagas o evasivas. Auditorías independientes han demostrado que Copilot difunde información inexacta sobre las elecciones europeas, desde fechas incorrectas hasta escándalos inventados.

Y no se limita a las consultas políticas. Un estudio de la BBC de febrero reveló que más de la mitad de las respuestas generadas por IA a partir de artículos de la BBC contenían errores importantes, como citas inventadas y afirmaciones falsas. Un análisis independiente del Centro Tow de la Universidad de Columbia repitió estos hallazgos, y advirtió que la IA distorsiona constantemente las noticias.

“Actualmente no se puede confiar en que los asistentes de IA proporcionen noticias precisas y corren el riesgo de engañar a la audiencia”, dijo Pete Archer, director del Programa de IA Generativa de la BBC.

Y mientras ChatGPT lidia con estos hechos básicos, Sam Altman, su creador, fue visto recientemente estrechando la mano del presidente Trump en Catar. Quizás el chatbot no recibió la información. N

(Publicado en cooperación con Newsweek. Published in cooperation with Newsweek)