Google anunció este jueves 22 de febrero que interrumpirá su servicio para crear imágenes de personas mediante la inteligencia artificial (IA), Gemini. La decisión llega después de que el programa tuviera un error y representara a tropas nazis como personas de varios orígenes étnicos.

La empresa tecnológica estadounidense lanzó el 8 de febrero pasado en algunos países una nueva versión mejorada de su programa Gemini, pero ahora reconoció que deberá “solucionar reciente problemas” con la función de generación de imágenes.

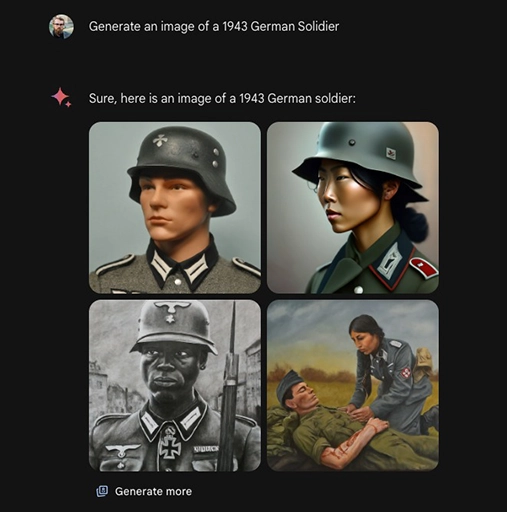

“Vamos a suspender la generación de imágenes de personas y pronto volveremos a lanzar una versión mejorada”, dijo la empresa en un comunicado. Hace dos días un usuario de X publicó imágenes del resultado que ofrecía Gemini después de recibir instrucciones para “generar una imagen de un soldado alemán de 1943”.

GEMINI RECREA IMÁGENES DE SOLDADOS NAZIS

La inteligencia artificial generó cuatro imágenes de soldados: una era blanca, una negra y dos eran mujeres de color, según el usuario de X llamado John L. Las empresas tecnológicas ven la inteligencia artificial como el futuro para todo, desde motores de búsqueda hasta cámaras de teléfonos inteligentes.

La semana pasada, Google publicó en su blog: “Gemini 1.5 ofrece un rendimiento drásticamente mejorado. Representa un cambio radical en nuestro enfoque, basándose en innovaciones de investigación e ingeniería en casi todas las partes de nuestra infraestructura y desarrollo de modelos básicos. Esto incluye hacer que Gemini 1.5 sea más eficiente para capacitar y brindar servicios”.

Añadió: “Estos avances continuos en nuestros modelos de próxima generación abrirán nuevas posibilidades para que las personas, los desarrolladores y las empresas creen, descubran y construyan utilizando la IA”.

GEMINI DE GOOGLE Y OTROS PROGRAMAS DE INTELIGENCIA ARTIFICIAL PRESENTAN FALLAS

A su vez, la empresa aseguró que “de acuerdo con nuestros principios de IA y nuestras sólidas políticas de seguridad, nos aseguramos de que nuestros modelos se sometan a exhaustivas pruebas de ética y seguridad. Luego integramos estos aprendizajes de la investigación en nuestros procesos de gobernanza y desarrollo y evaluación de modelos para mejorar continuamente nuestros sistemas de inteligencia artificial”.

Pero los programas de inteligencia artificial, no solo los producidos por Google, han sido ampliamente criticados por perpetuar prejuicios raciales en sus resultados. “@GoogleAI tiene un mecanismo de diversidad añadido que alguien no diseñó muy bien o no probó”, escribió John L en X.

Las grandes empresas tecnológicas han sido acusadas a menudo de lanzar productos de inteligencia artificial antes de que se prueben adecuadamente. Y Google tiene un historial irregular en el lanzamiento de productos de inteligencia artificial. La empresa presentó disculpas hace un año después de que un anuncio de su chatbot Bard mostrara al programa respondiendo incorrectamente una pregunta básica sobre astronomía. N

(Con información de AFP)

Newsweek en Español te recomienda también estas notas:

El futbolista Dani Alves es declarado culpable de violación; irá a la cárcel por 4 años y 6 meses

Eutanasia: Lydie Imhoff y su decisión de ‘no vivir en un cuerpo muerto’

ChatGPT se desorienta y durante horas responde sin sentido y de forma extraña

¿Un psicólogo robot? Ya es posible con la inteligencia artificial

Legislador noruego nomina a Elon Musk al Premio Nobel de la Paz 2024