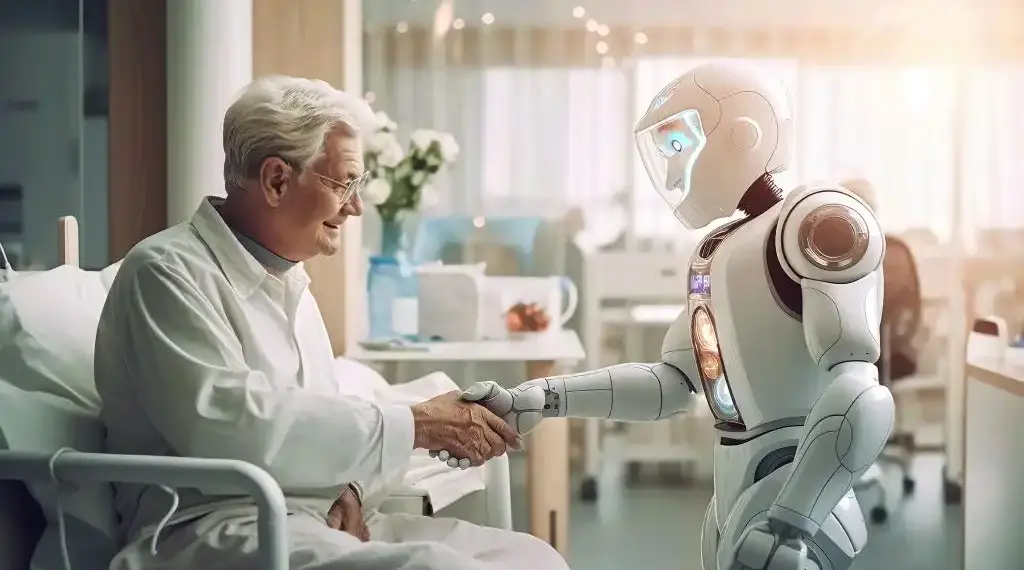

Un sistema de inteligencia artificial (IA), entrenado para realizar entrevistas médicas, superó el desempeño de los doctores al conversar con pacientes simulados y enumerar posibles diagnósticos con base en el historial clínico de las personas.

De acuerdo con un nuevo estudio publicado en arXiv, un archivo en línea para las prepublicaciones de artículos científicos, el chatbot, que se basa en un modelo de lenguaje grande (LLM) desarrollado por Google, fue más preciso que los médicos de atención primaria certificados en el diagnóstico de afecciones respiratorias y cardiovasculares, entre otras. Además de conseguir una cantidad similar de información durante las entrevistas médicas, obtuvo una puntaje más alto en empatía.

“Hasta donde sabemos, esta es la primera vez que un sistema de IA conversacional se ha diseñado de manera óptima para el diálogo de diagnóstico y la toma de la historia clínica. Queremos que los resultados se interpreten con cautela y humildad”, afirma Alan Karthikesalingam, científico de investigación clínica de Google Health en Londres y coautor del estudio.

De nombre Articulate Medical Intelligence Explorer (AMIE), el chatbot continúa siendo experimental. Hasta ahora, no se ha probado en personas con afectaciones reales, solo en actores capacitados para representar a individuos con problemas médicos.

Aunque el chatbot está lejos de utilizarse en la atención clínica, los autores sostienen que eventualmente podría desempeñar un papel en la democratización de la vigilancia médica. Para Adam Rodman, médico internista de la Facultad de Medicina de Harvard, aunque la herramienta podría ser útil, esta no debería reemplazar las interacciones con los profesionales de salud.

“La medicina es mucho más que recopilar información: se trata de relaciones humanas”, dice.

EL SISTEMA DE IA SUPERA A LOS DOCTORES EN LOS CRITERIOS DE “CALIDAD DE LA CONVERSACIÓN”

Uno de los principales desafíos que enfrentaron los desarrolladores del chatbot fue la escasez de conversaciones médicas del mundo real, disponibles para usar como datos de entrenamiento, argumenta Vivek Natarajan, investigador de inteligencia artificial en Google Health.

Para probar el sistema, detalla el estudio retomado por Nature, los investigadores reclutaron a 20 personas que habían sido capacitadas para pasar por pacientes y les consiguieron que tuvieran consultas en línea basadas en mensajes de texto, tanto con AMIE como con 20 médicos certificados. No se les informó si estaban conversando con un humano o con un robot.

Los actores simularon 149 escenarios clínicos y luego se les pidió evaluar su experiencia. Un grupo de especialistas también calificó el desempeño de la AMIE y el de los profesionales de salud. Los resultados arrojaron que el sistema de IA igualó o superó la precisión del diagnóstico en las seis especialidades médicas consideradas.

Asimismo, el robot superó a los médicos en 24 de 26 criterios de calidad de la conversación, incluida la cortesía, explicación de la afección y el tratamiento, la apariencia honesta y la expresión de atención y compromiso.

“Probablemente los médicos de atención primaria del estudio no estaban acostumbrados a interactuar con los pacientes a través de un chat de texto y esto podría haber afectado su desempeño. Un LLM tiene la injusta ventaja de poder redactar rápidamente respuestas largas y bellamente estructuradas”, señaló Alan Karthikesalingam.

Ahora, el equipo de Google está empezando a investigar los requisitos éticos para probar el sistema con humanos que tienen problemas de salud reales. N